1. 들어가며

챗지피티(ChatGPT)는 인간이 던진 기본적인 질문을 이해하고, 언어를 다루는 능력 또한 상당함을 보여주고 있다.

이로 인해 사람들은 챗지피티가 인간 지식 전체를 학습하였고, 따라서 인간이 할 수 있는 많은 복잡한 작업들을 수행할 수 있을 것이라고 추정하게 되었다.

챗지피티와 같은 일반 대화형 대규모 언어 모델(LLM)의 기본 형태는 프로그램의 불완전성, 요청한 주제에 대한 그럴듯한 허구와 거짓 정보 제공(https://bit.ly/47ssZD3), 기본 수학에서의 한계(https://bit.ly/3RhD4xh) 등의 많은 문제를 보여주었다.

물론 빠른 속도로 진화하며 그 문제를 극복해가고 있기는 하다. 그렇다면 2023년 12월 현재를 기준으로 할 때 생성형 AI는 과연 연구 목적으로 활용가능한 것일까? 이 글에서는 결과의 사실적 정확성이 요구되는 연구용으로도 활용할 수 있을지에 대해 살펴보고자 한다.

2. 최근 챗지피티 개선: 챗지피티 플러스 구독 또는 챗지피티, 기업을 위한 챗지피티

잘 아다시피 챗지피티를 개발한 오픈AI는 챗지피티 플러스 구독자나 챗지피티 엔터프라이즈를 사용하는 조직들을 위한 새로운 기능을 출시했다. 사용자들은 파일을 업로드하고 챗지피티가 질문에 답할 때 그 파일을 활용하도록 할 수 있다.

요약, 집계, 업로드된 소스를 기반으로 한 질문에 대한 답변 등이 제안된 사용 사례이다. 사용자가 문서를 제공하기 때문에 이론적으로 챗지피티가 생성한 정보는 그 문서에서 나와야 하며, 결과적으로 허구가 생성되지 않을 것으로 예상한다.

하지만 챗지피티에게 제공된 문서만이 아니라 외부와 연결을 하거나, 추론을 하거나 문서의 내용을 검증하라고 요청하는 순간, 기본 버전의 LLM이 일반적으로 보여주는 문제와 유사한 문제가 생길 가능성이 높다.

3. 대규모 언어 모델을 장착한 새로운 검색엔진 (Google의 Bard, Microsoft Bing AI, Perplexity AI/Copilot)

대화형 LLM이 등장하자 마이크로소트와 구글은 이를 활용하여 새로운 검색엔진을 출시했다. 마이크로소프트는 오픈AI와 파트너십을 맺고 그들의 GPT-4 모델을 사용하여 빙(Bing) AI를 개발했다. 빙 AI는 질문 대한 답변을 제시할 때 마이크로소프트 자체 검색 엔진인 빙을 활용한 결과를 인용으로 제시하는 경향이 있다.

Google은 자체 PaLM 2(https://ai.google/discover/palm2/)를 기반으로 한 대화형 LLM인 바드(Bard)(https://bard.google.com)를 개발했다. PaLM은 기술 보고서(https://bit.ly/410sU7i, https://bit.ly/3QZpr4g)에 의거한 대화형 데이터를 더 많이 사용하여 훈련한 것으로 보인다.

그래서 일부 사용자들은 PaLM이 더 친근하고 대화에 적합하다고 생각하는 것 같다. 하지만 요청한 결과를 검색 엔진과 통합하여 제시하기보다는, 사용자가 생성된 결과를 보고 버튼을 클릭하여 정보를 확인할 수 있도록 하고 있다. 가령 바드에서 영어로 질문할 경우 응답 마지막 부분에 다음과 같은 아이콘이 나타난다.

그중에서 구글 아이콘을 클릭하면 제시된 결과물 중에서 검증할 수 있는 문장들은 녹색으로, 의심스러운 것으로 판단되는 문장들은 주황색으로 강조가 된다. 강조 표시가 없는 문장은 자신 있게 검증할 수 없는 것을 나타낸다.

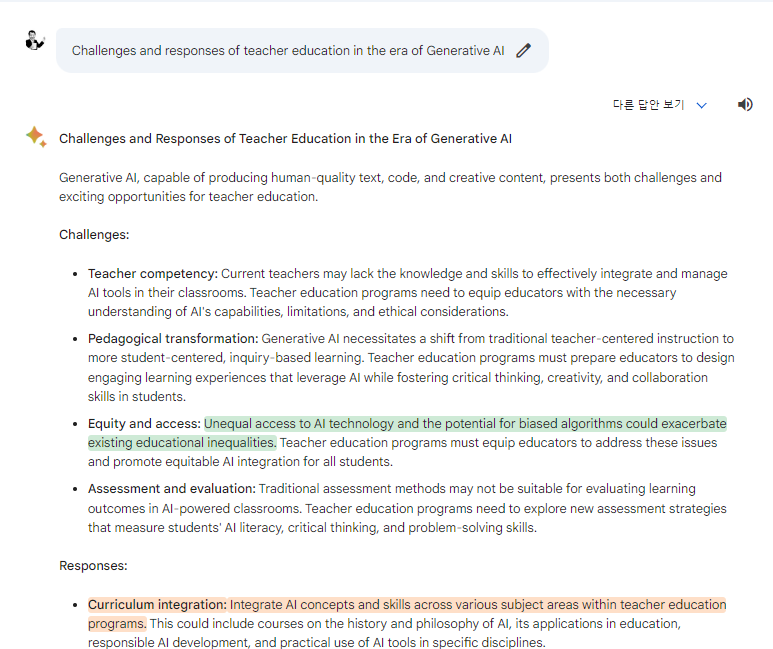

이하 내용은 “생성 AI 시대 교사교육이 직면한 도전과 대응”이라는 명령을 영어로 입력한 후 나온 결과에 대해 하단부의 구글 표시 아이콘을 클릭한 결과 나타난 것이다.

이하에서 보는 것처럼 녹색과 주황색으로 표시된 문장이 있다. 한국어로 질문하면 구글 아이콘이 보이지 않는다. 즉, 한국어의 경우 아직은 내용 검증 서비스가 제공되지 않고 있다.

더 나은 제품을 만들기 위해 오픈AI의 전 연구원과 Facebook의 전 AI 연구원이 설립한 Perplexity는 자체 내부 검색 엔진을 사용하고, 다른 대화형 LLM이 제공하는 주요 기능들을 통합한 Perplexity AI(https://www.perplexity.ai/)를 만듦으로써 기능을 향상시키고 있다고 한다.

마이크로소프트의 빙 AI처럼 Perplexity AI는 질문에 답할 때 자체 검색 엔진의 검색 결과를 기반으로 출처를 제공하는데 무료 버전은 GPT-3.5를 활용하고 있다.

Perplexity는 Perplexity Copilot이라는 더 강력한 버전도 제공하고 있다. 이는 Anthropic의 Claude 2 또는 GPT-4를 사용할 수 있게 해주지만, 구독하지 않으면 4시간마다 5개의 질문만 할 수 있다(https://bit.ly/3T3knPc). <다음에 계속>

그래도 삭제하시겠습니까?

댓글을 남기실 수 있습니다.